category

tags

type

status

slug

date

summary

icon

password

前言

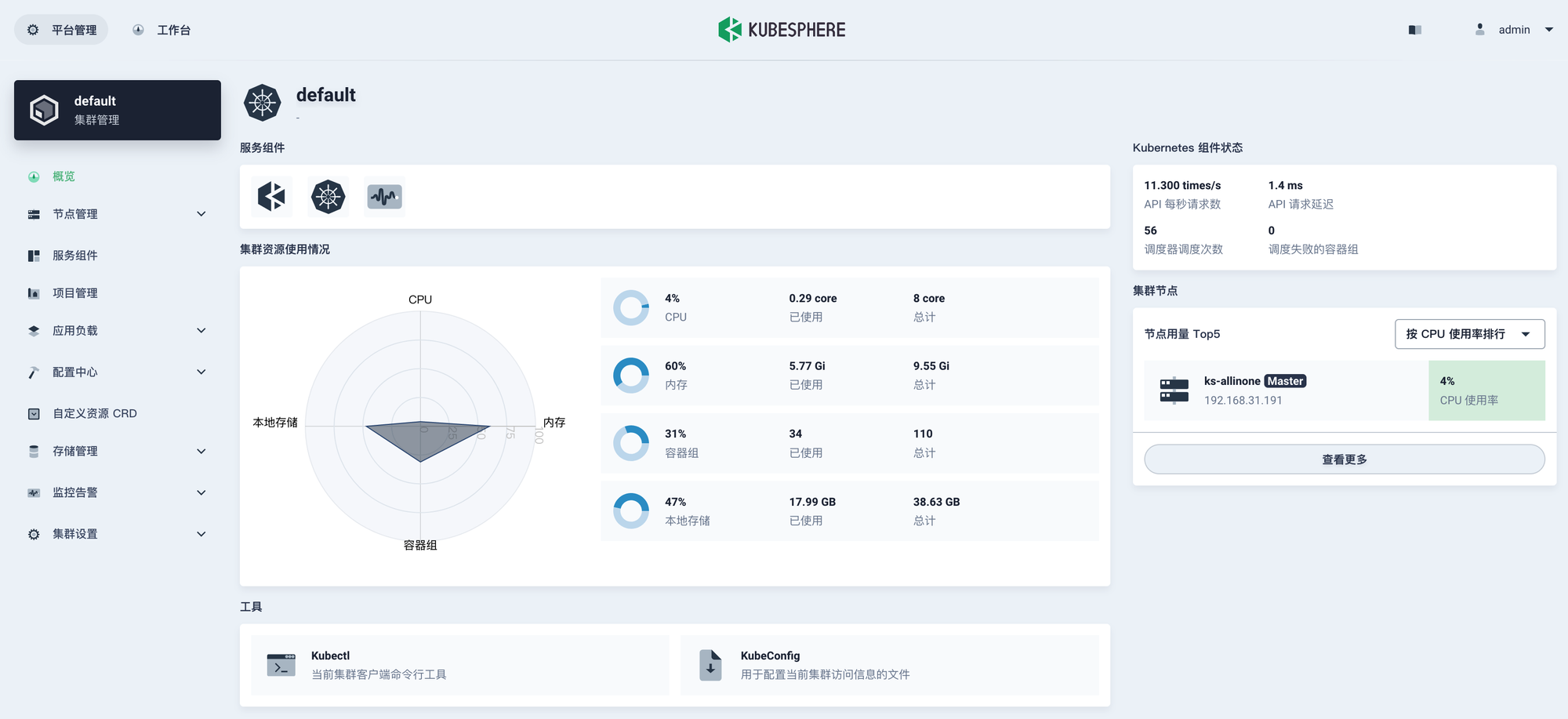

实际操作中都是使用KubeSphere作为k8s的默认可视化界面使用。它可以方便地管理k8s环境中的各个元素。

创建各个中间件

1. MySQL

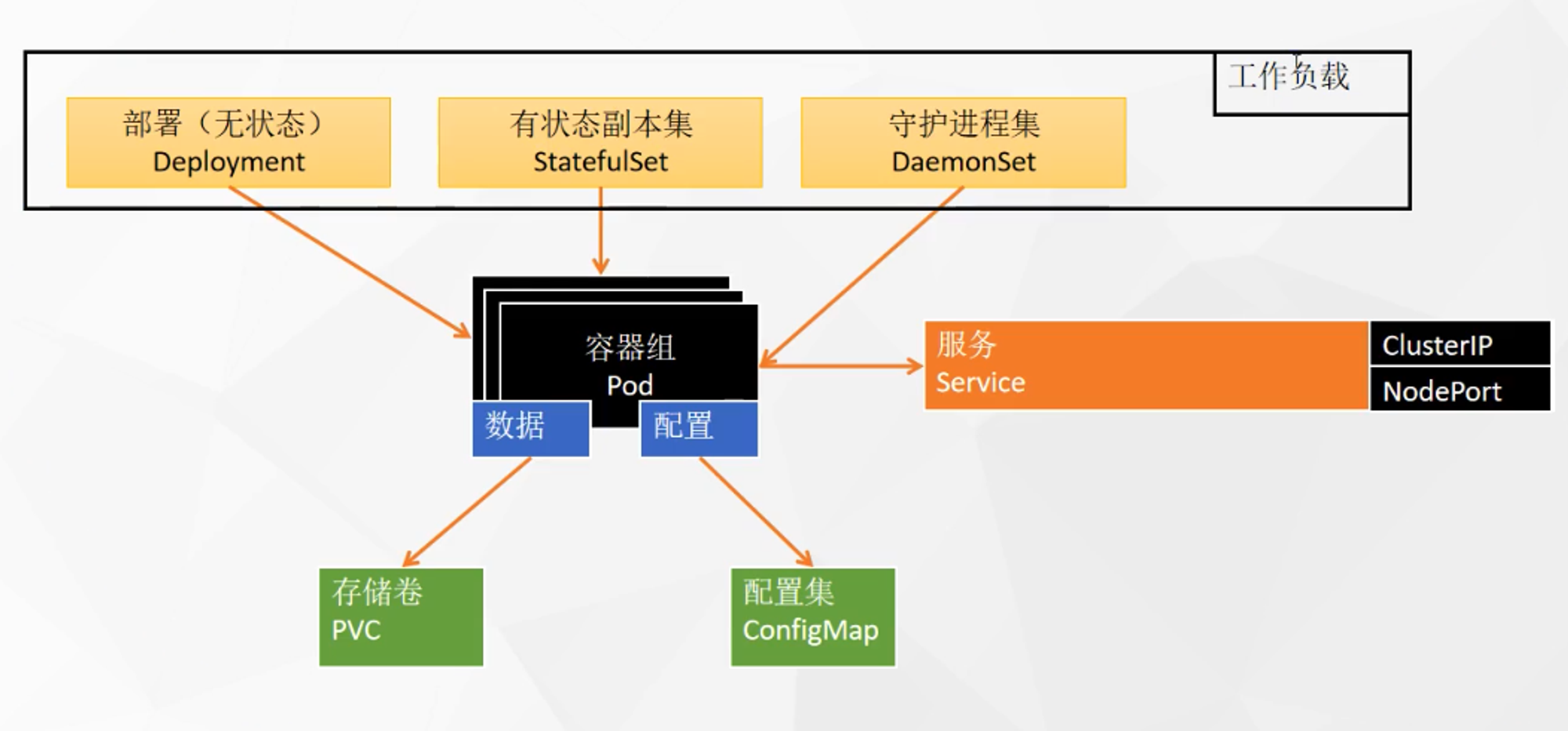

核心三要素

部署方式(StatefulSet),数据存储 (PVC),配置文件(ConfigMap)。

开始前准备

可在官方镜像文档描述查看mysql容器启动的相关配置

传统 Docker的启动方式

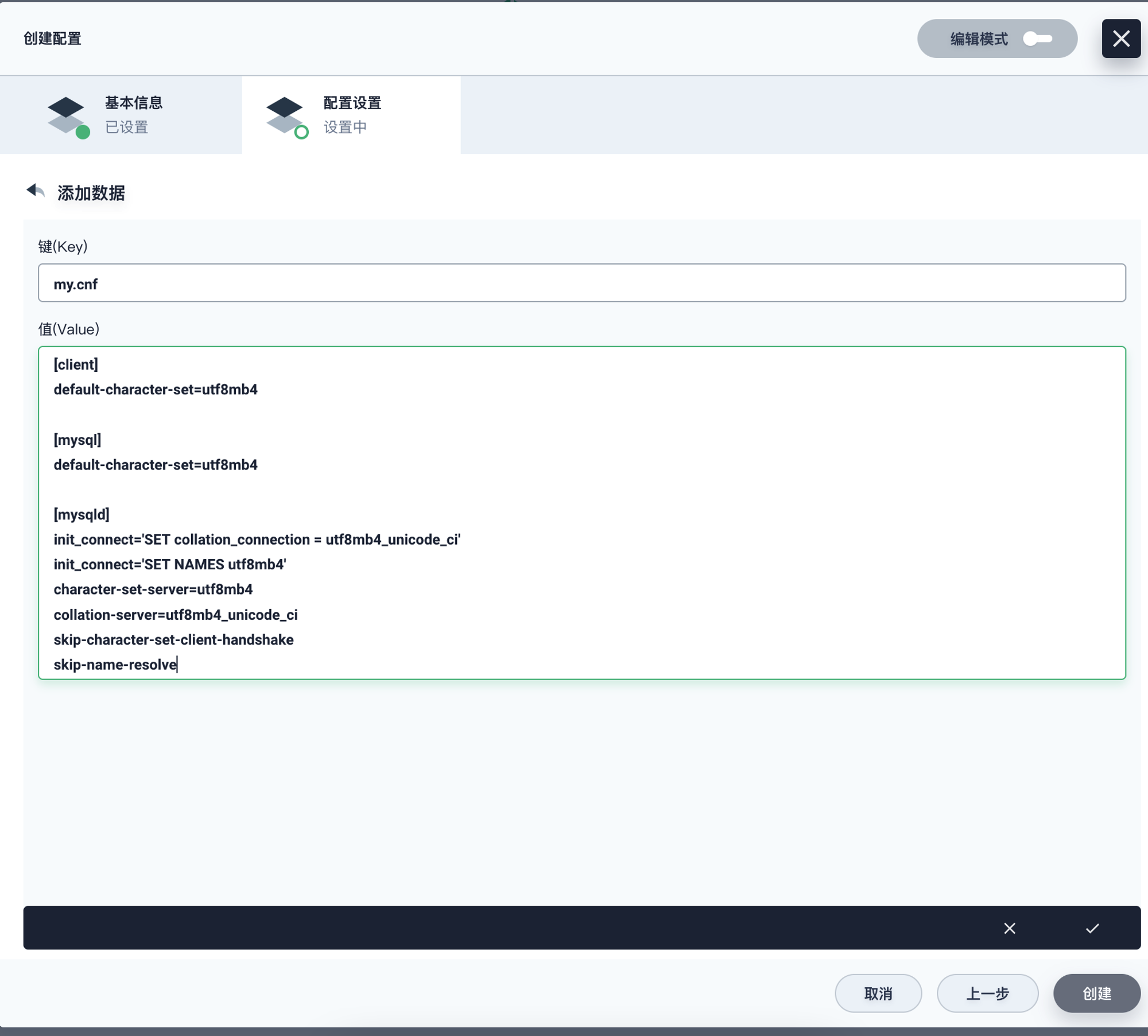

创建配置configmap

- 在配置项中添加配置

- 添加一个key-value配置,key就是配置文件的文件名 这里是

my.cnf

my.cnf的内容,填写的是数据库服务端的配置

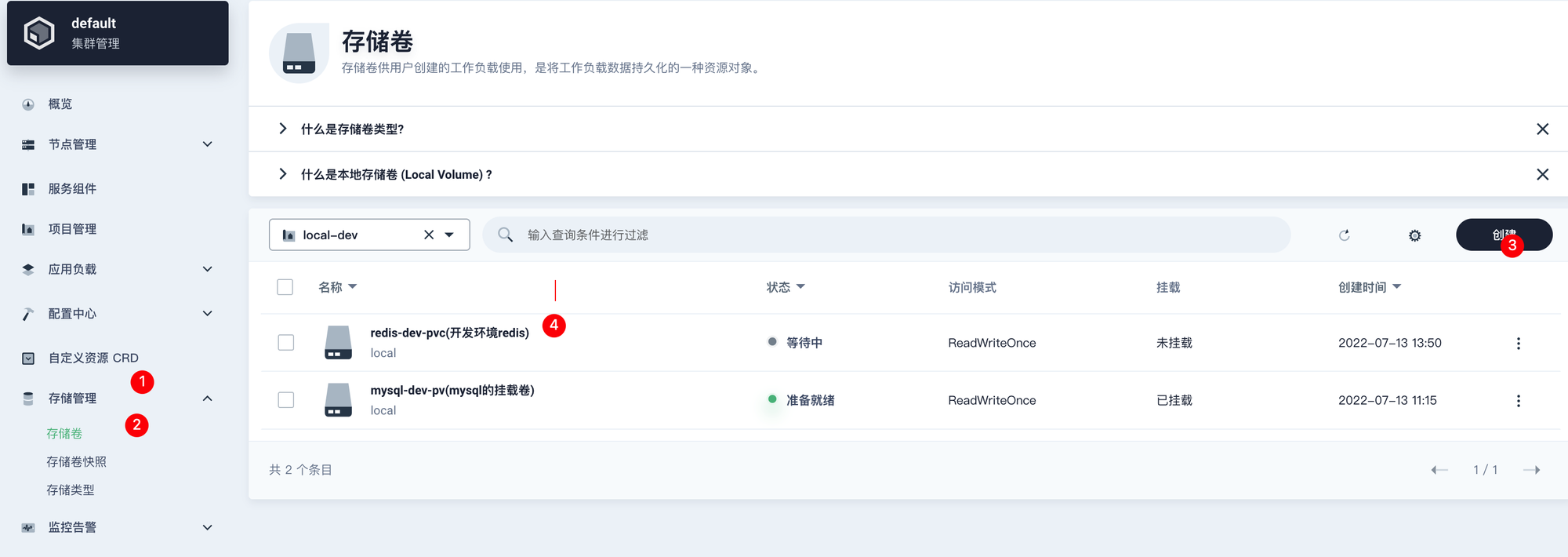

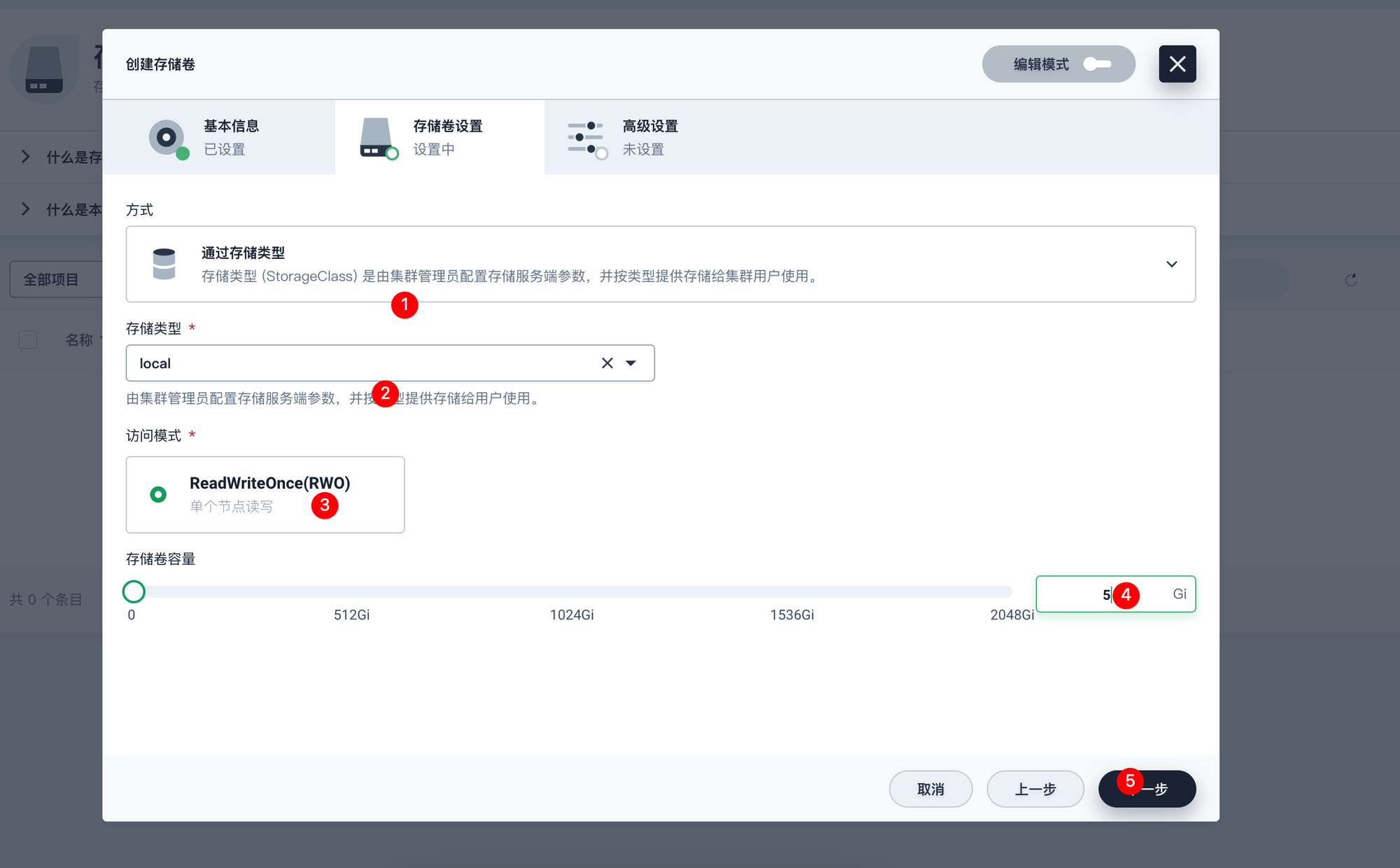

创建 挂载卷

- 创建卷

- 设置存储类型和访问模式以及卷容量

添加工作负载

- 在部署工作负载中选择有状态负载

- 镜像 配置为dockerhub中的mysql,并使用镜像默认端口设置

- 镜像环境变量,根据mysql镜像的官方要求,需要添加一个

MYSQL_ROOT_PASSWORD;创建后点击下一步

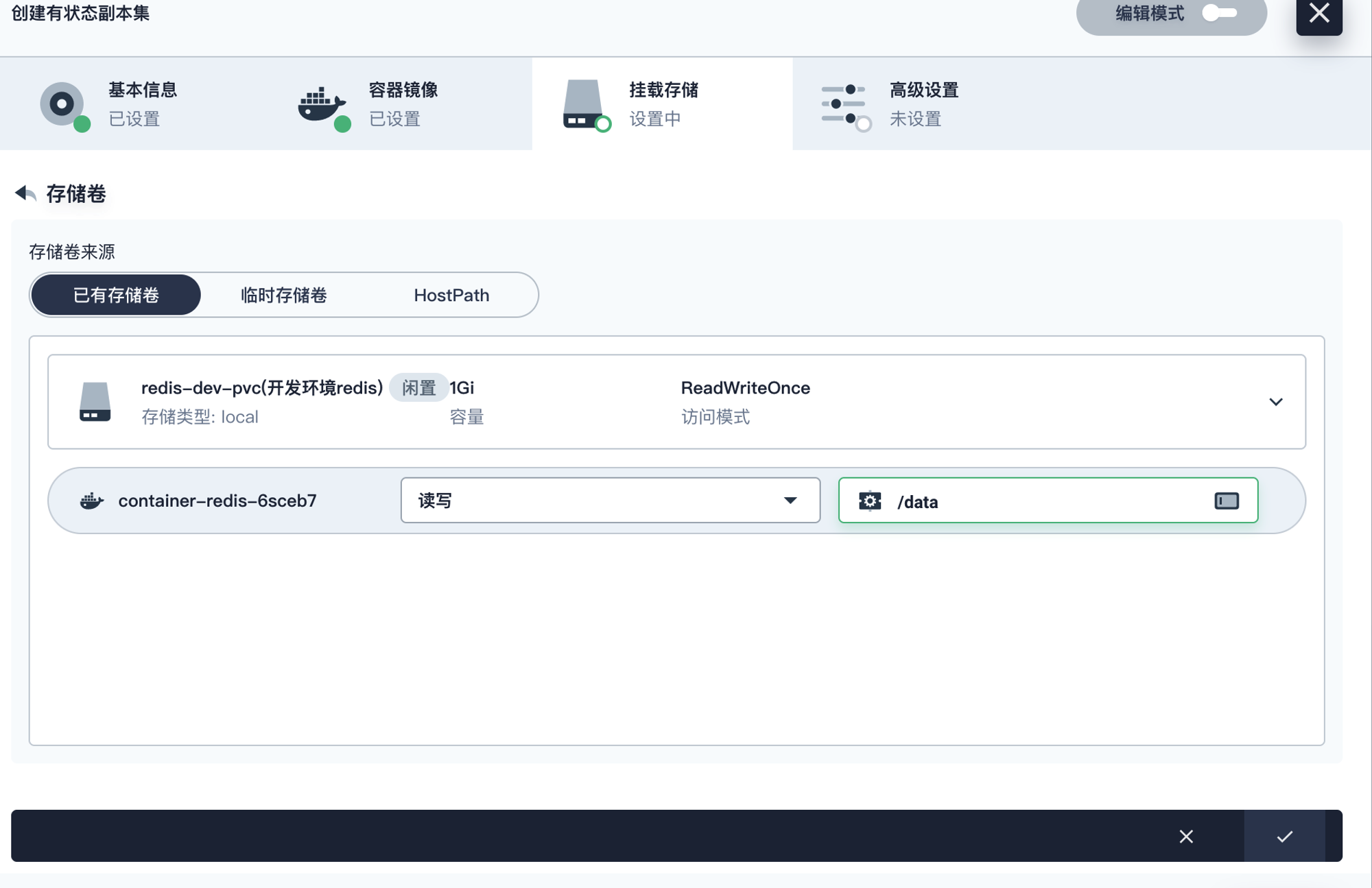

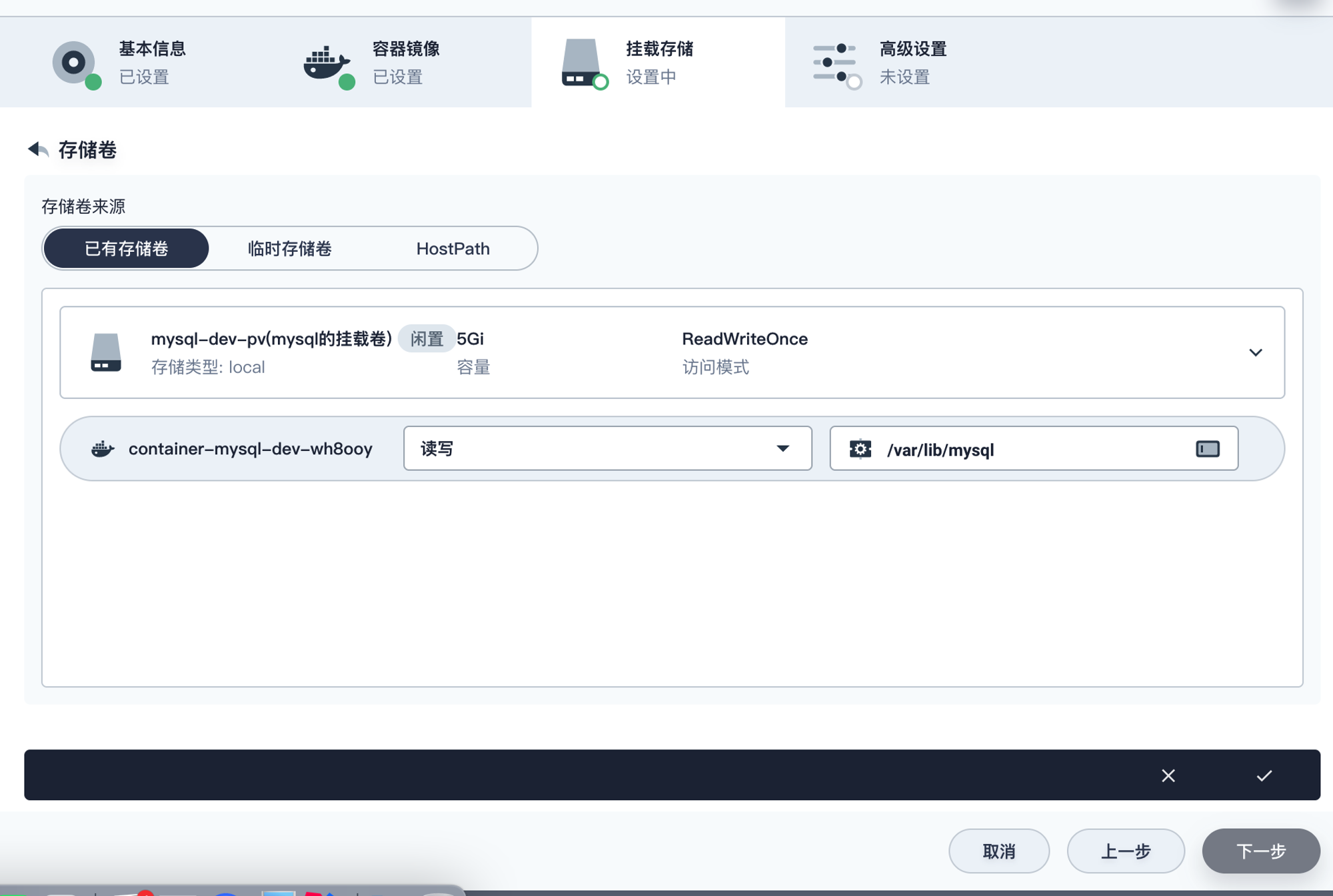

- 挂载存储卷

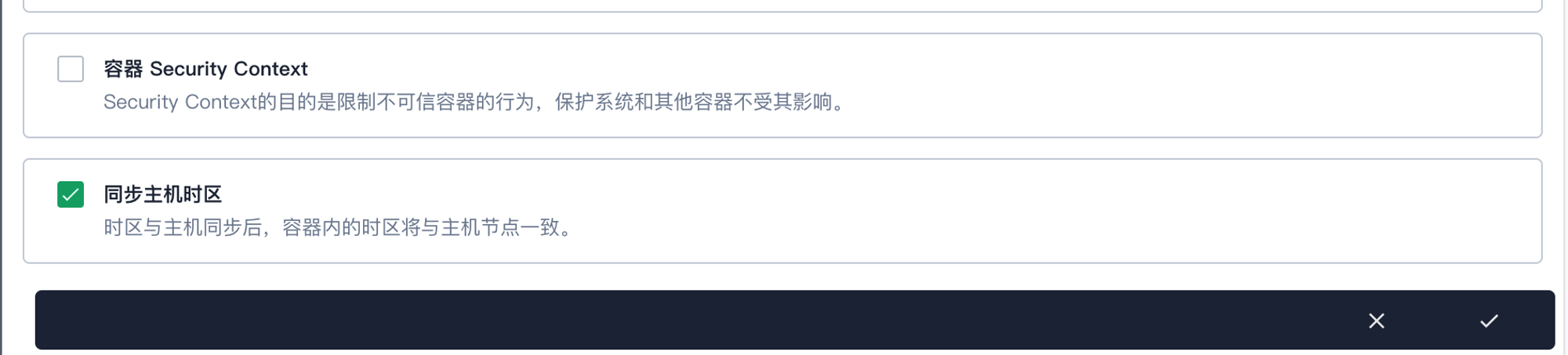

- 挂载配置卷

指定配置卷的挂载目录

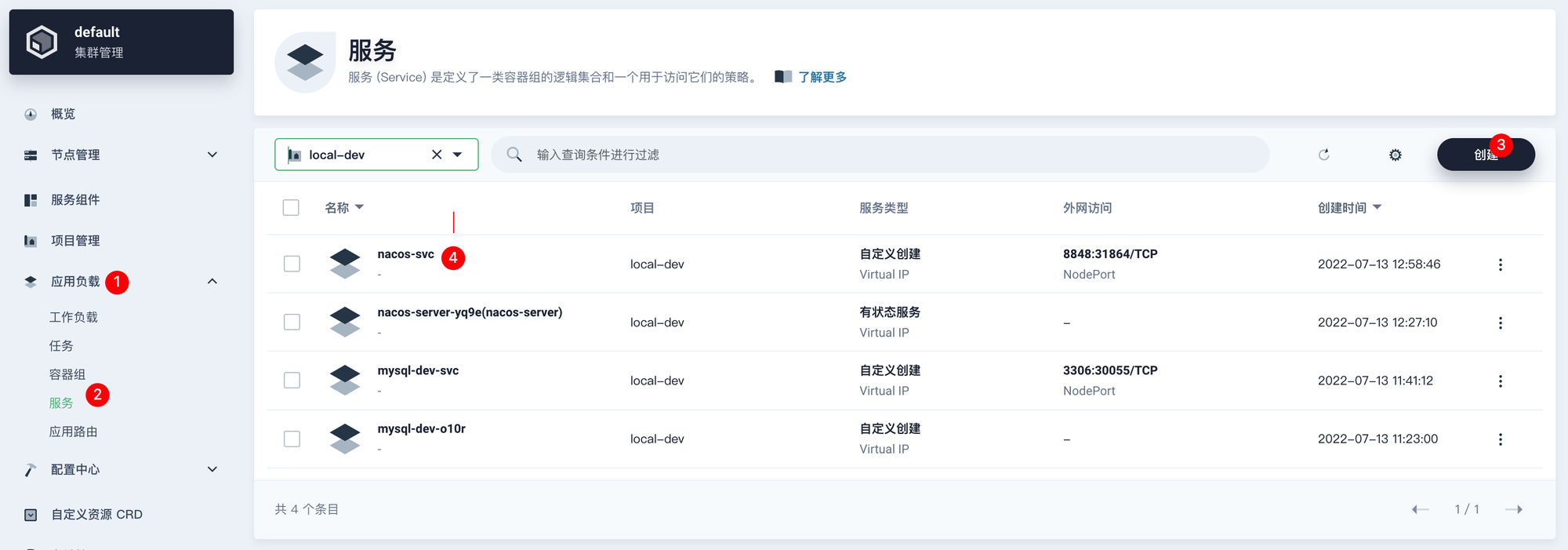

对外 提供服务

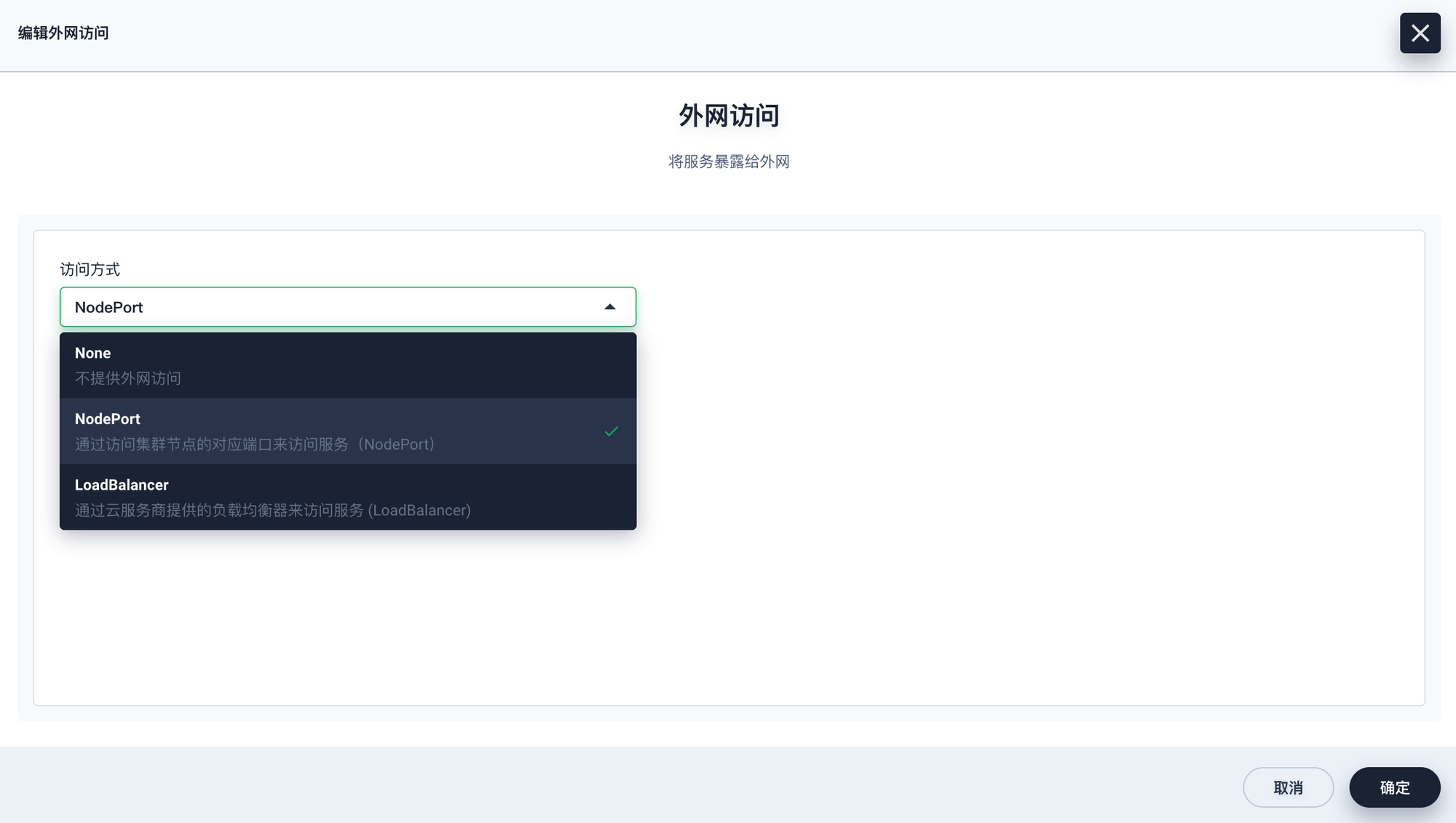

- KS默认会创建一个内网服务,可以选择修改,或重新创建一个NodePort对外服务

- NodePort类型表示可以从集群中的任意节点IP进行访问

- 访问地址,如图冒号后的地址就是外部访问的端口号

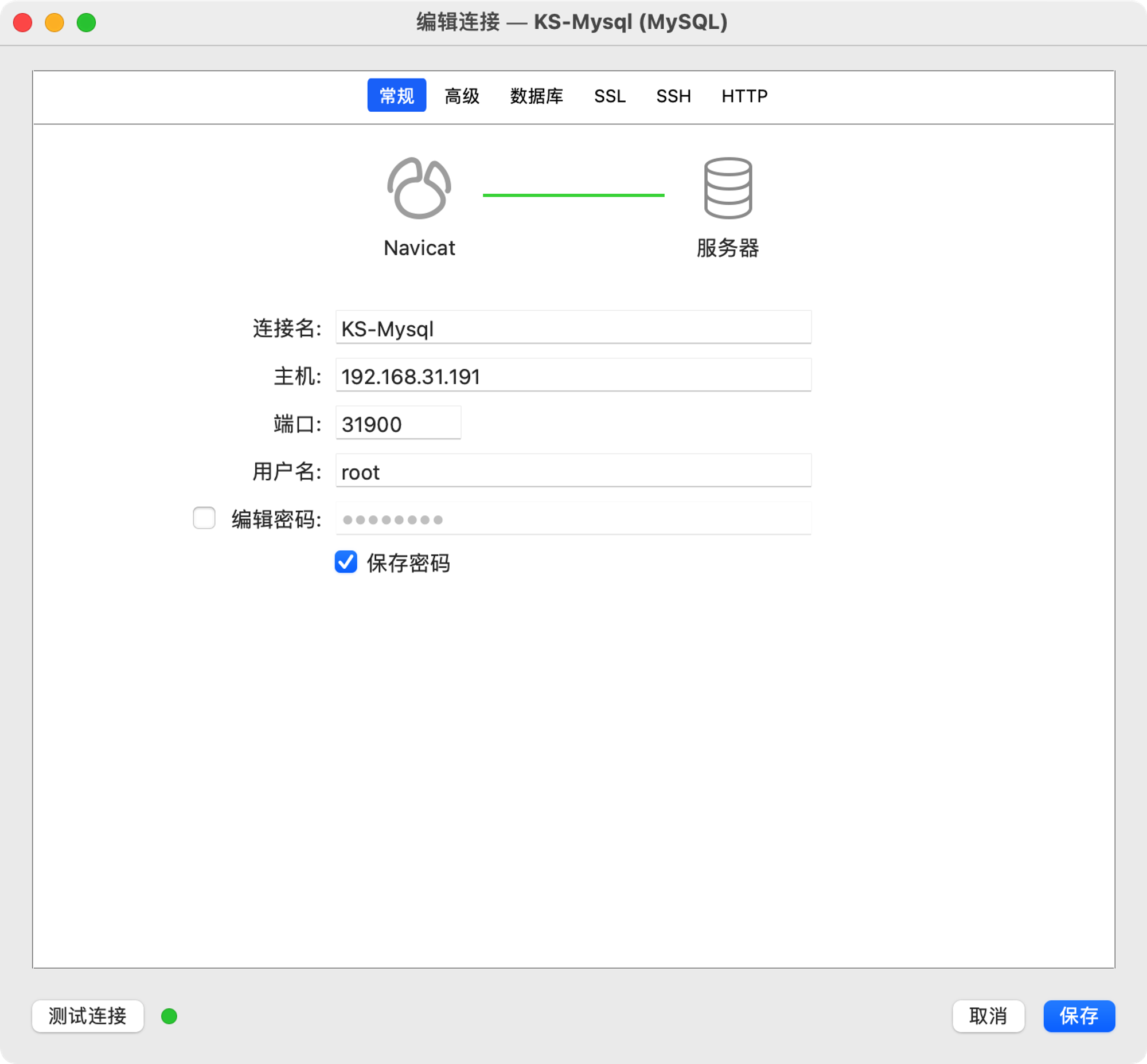

- 访问客户端测试

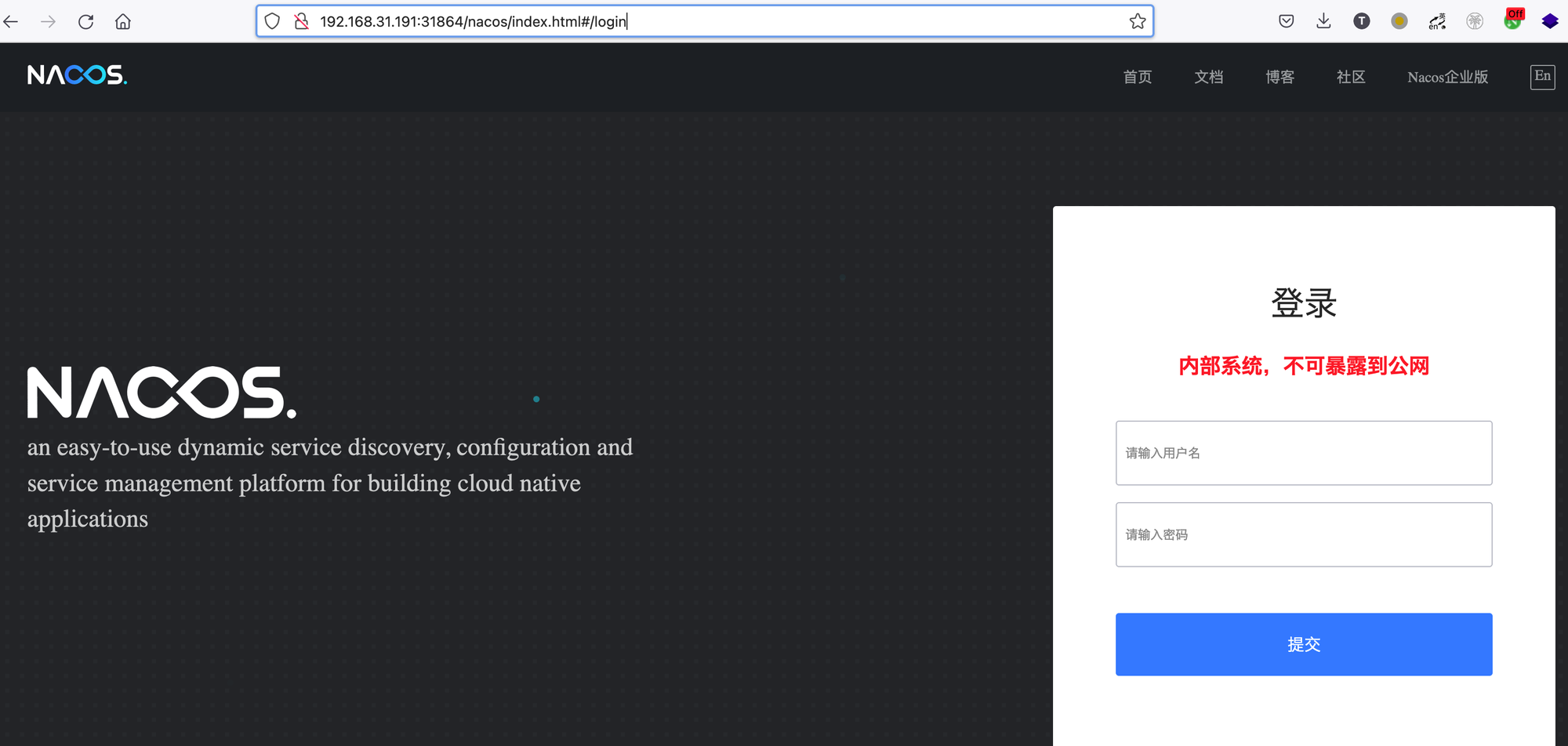

2. Nacos

3. Redis

4. SEATA

部署前准备

官方文档的Docker部署方式

seata 连接到Nacos,由nacos托管 seata的配置;同时客户端是通过nacos的注册中心中获取seata的地址。

创建配置文件CM

我这里需要将SEATA注册到nacos中,使用nacos进行配置,用mysql进行undo_log的存储,需要修改

application.yml文件,配置参考如下:创建有状态副本

- 查找镜像

- 开放端口

7091是面板的地址 ,8091是 服务端口地址

- 挂载配置文件,注意,我们这里只修改

application.yml配置文件,为了不覆盖容器中/seata-server/resources目录下的其它配置文件,这里要使用子路径配置。

暴露服务

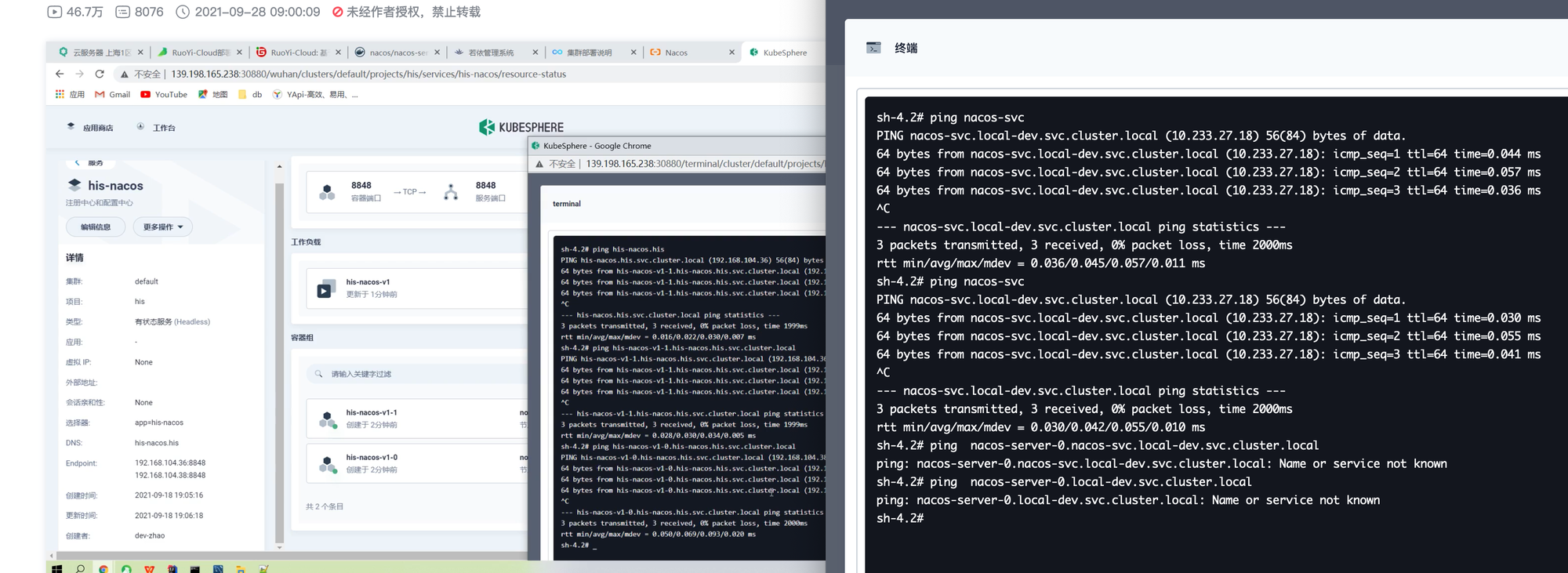

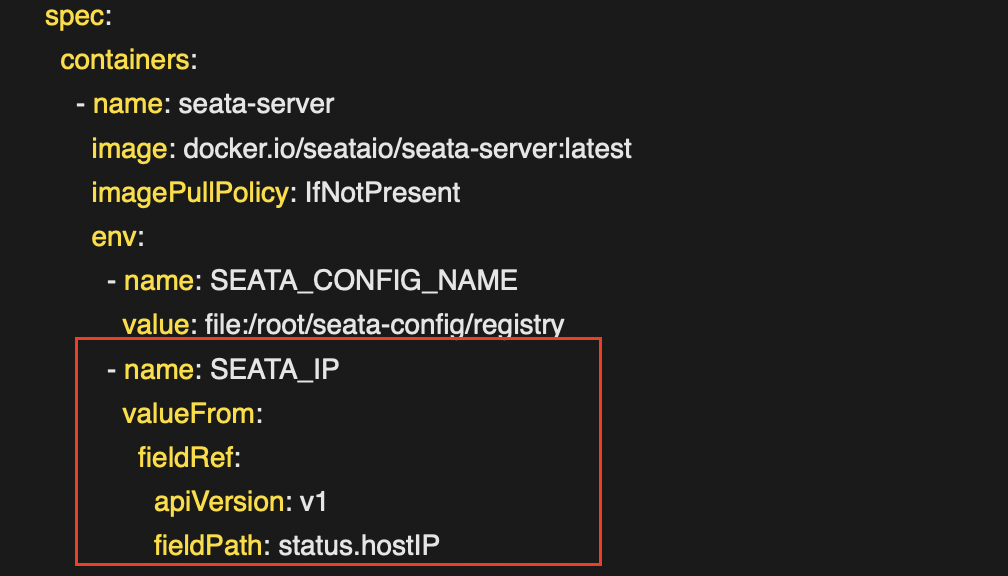

此方案部署后,seata-server虽然部署成功,但是注册到Nacos上的IP是Kubernetes内部集群IP,seata客户端应用是无法访问到seata-server服务的,除非nacos和seata客户端应用也部署在Kubernetes集群内部,但显然目前无法进行这么大的变革。

所以解决问题的方法就是让seata-server的注册IP是宿主机IP.

定义SEATA的外部IP

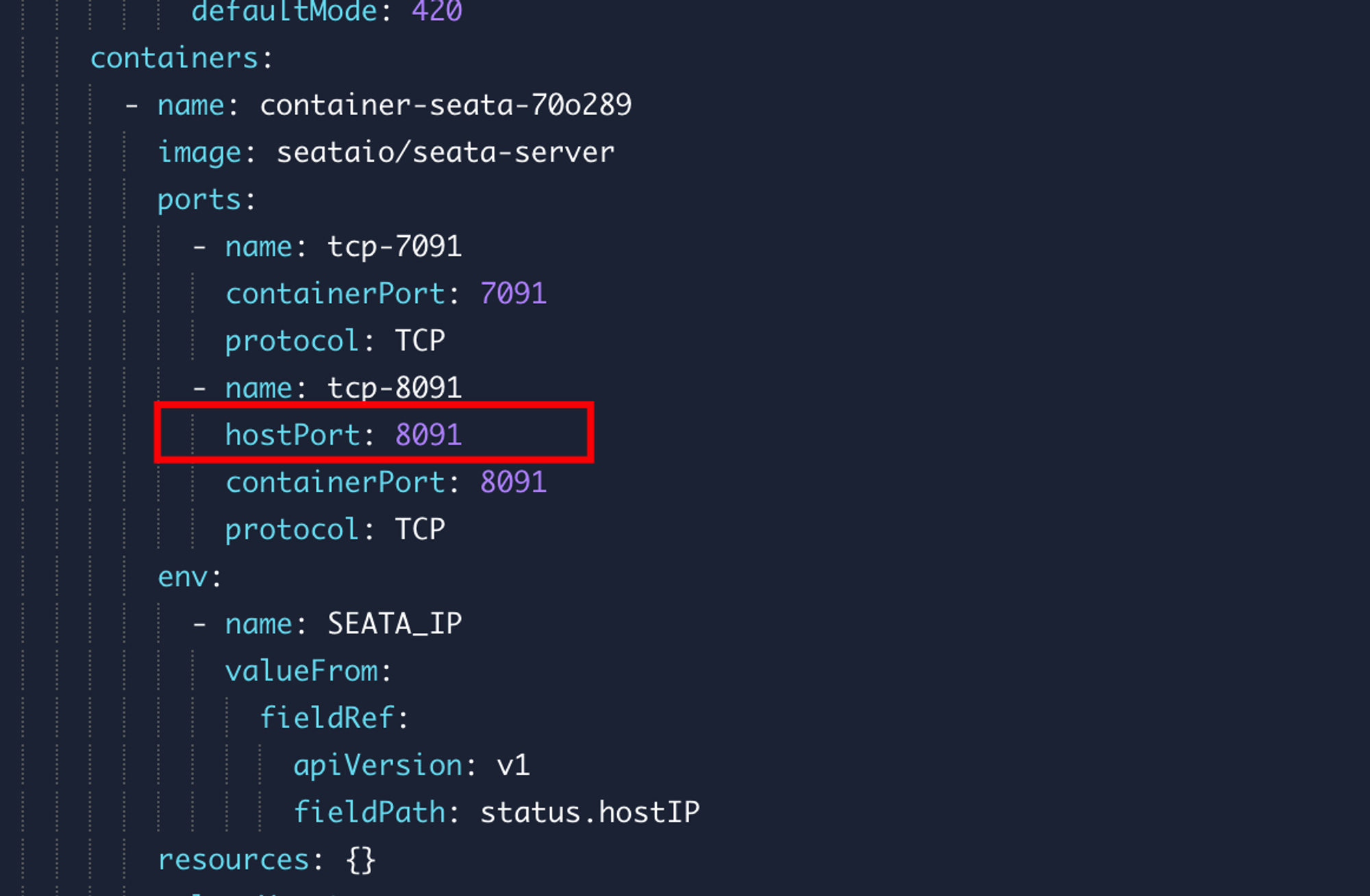

定义SEATA的外部端口

k8s如果用NodePort方式暴露端口的话端口必须是30000-32765之间的端口号,但是在容器中默认配置的端口是8091,这就会导致连接不上,要从外部访问的折中之计就是先利用hostPort将容器的端口直接在宿主机上暴露。

这样做会占用了宿主机唯一的8091端口,要注意实例数不能大于节点机数,否则多出来的会无法部署。

通过Mysql存储实现Seata的高可用

开始前准备

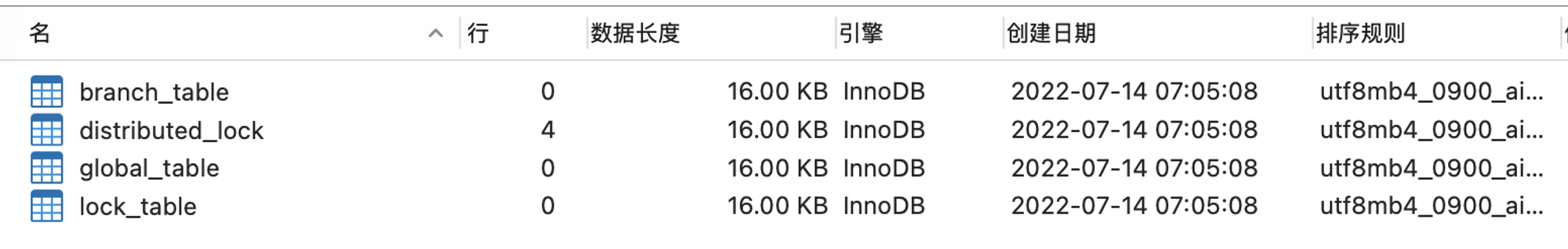

创建seata的数据库,并且执行官方的初始化脚本 mysql.sql , 数据库建完效果如下,我目前用的是1.5.2版本的脚本:

在NACOS中配置Seata的Store类型为DB

创建

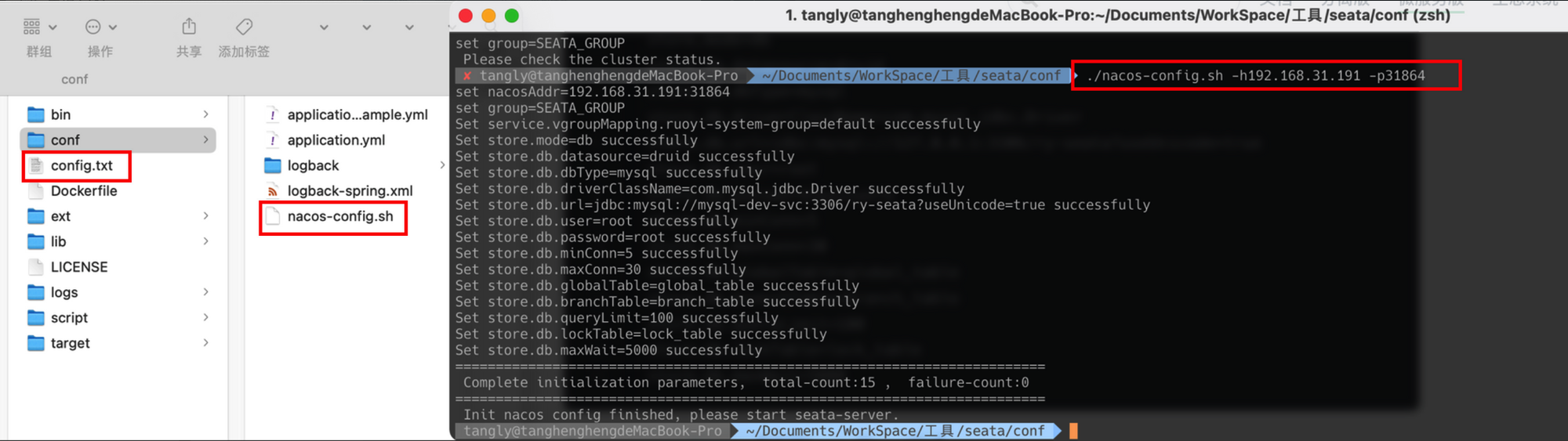

/config.txt,并填写数据库配置如下:创建一个nacos配置导入脚本 /conf/nacos-config.sh 内容点击展开:

执行脚本,后面跟上nacos的ip和端口,例如:

./nacos-config.sh -h192.168.31.191 -p31864

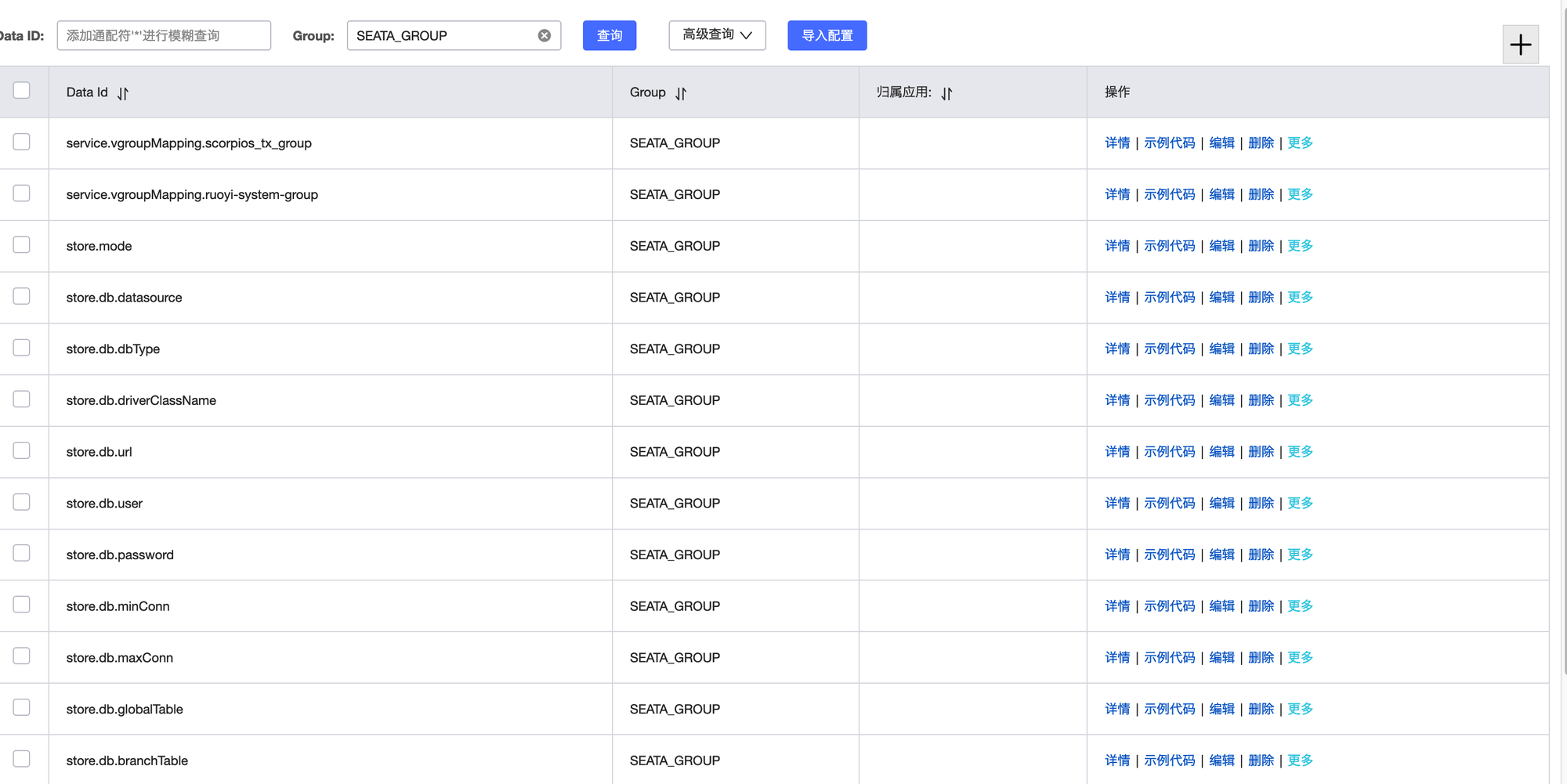

配置添加成功的效果如下:当然这些配置你也可以在NACOS中逐一添加

- 导入配置后,重新启动Seata,若日志结尾出现

{dataSource-1} inited表示Seata 成功连接mysql

相关

- 作者:NotionNext

- 链接:https://tangly1024.com/kubesphere-k8s-middleware-mysql-redis-nacos-sentinel-seata

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。